1. 下载安装包

2. 解压

cd /usr/local/softs

tar -zxvf hadoop-2.7.7.tar.gz3. 修改host映射

vi /etc/hosts

192.168.209.129 node1

4. 修改配置

配置文件在目录/usr/local/softs/hadoop-2.7.7/etc/hadoop/

<!-- 文件名 core-site.xml -->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://node1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/softs/hadoop-${user.name}</value>

</property>

</configuration><!-- 文件名 hdfs-site.xml -->

<configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration><!-- 文件名 mapred-site.xml 拷贝自mapred-site.xml.template -->

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration><!-- 文件名 yarn-site.xml -->

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>node1</value>

</property>

</configuration><!-- 文件名 core-site.xml -->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://node1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/softs/hadoop-${user.name}</value>

</property>

</configuration>vi slaves

node 15. 配置环境变量(默认java环境已安装,配置)

vi /etc/profile

export HADOOP_HOME=/usr/local/softs/hadoop-2.7.7

export PATH=${PATH}:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin

export HADOOP_CLASSPATH=`hadoop classpath`

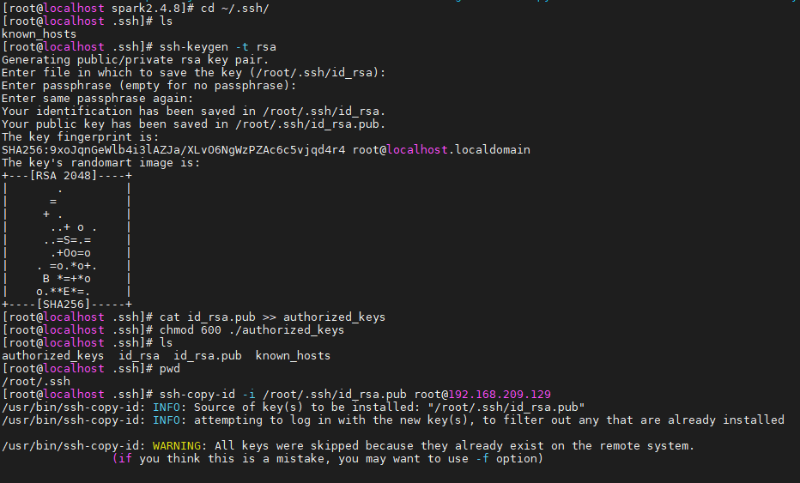

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop6. ssh免密登录配置

如果没有配置免密登录的话每次登录到这台服务器都要输入密码

[root@localhost spark2.4.8]# ssh 192.168.209.129

在本地机器(192.168.209.129)生成私钥和公钥

[root@localhost ~]# cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

[root@localhost .ssh]# ssh-keygen -t rsa # 会有提示,都按回车就可以

[root@localhost .ssh]# cat id_rsa.pub >> authorized_keys # 加入授权

[root@localhost .ssh]# chmod 600 ./authorized_keys # 修改文件权限

将公钥上传到远端机器(在此为本机)

[root@localhost .ssh]# ssh-copy-id -i /root/.ssh/id_rsa.pub root@192.168.209.129

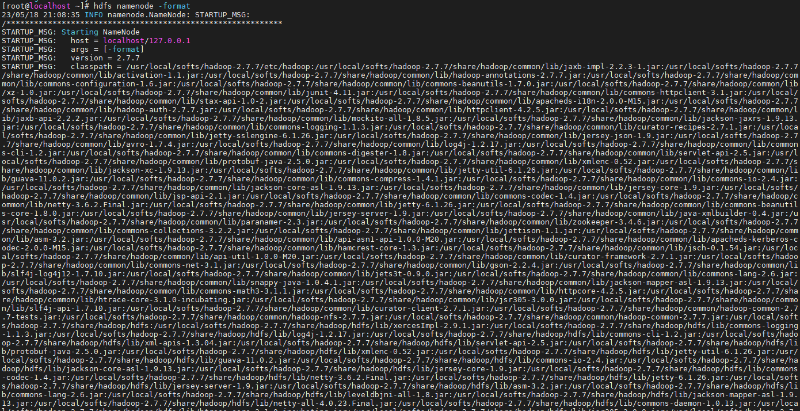

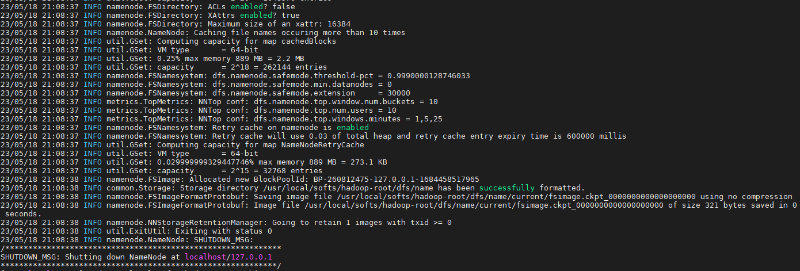

7. 格式化namenode

hdfs namenode -format

看到 Storage directory /mydata/data/hadoop-root/dfs/name has been successfully formatted. 则表示成功。

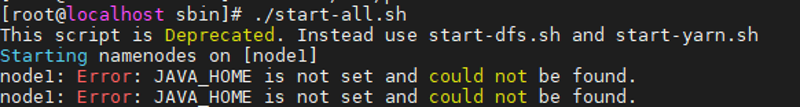

8. 启动

sbin目录下:

./start-all.sh

如果报错:

需要配置:

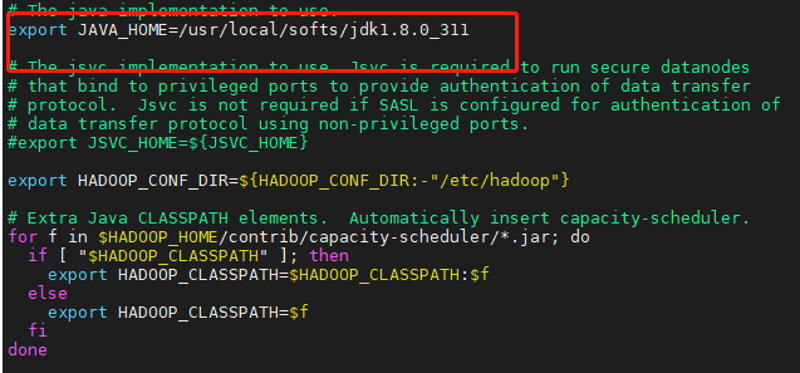

vi hadoop-env.sh

将JAVA_HOME路径改为自己的jdk路径

9. 测试

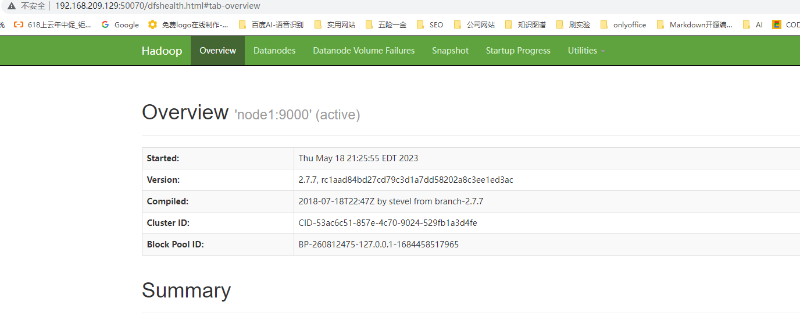

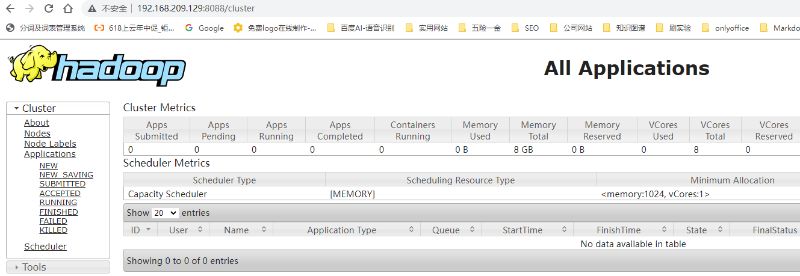

通过浏览器可以访问以下地址:

| namenode的后台 | http://node1:50070 |

| yarn资源管理的后台 | http://node1:8088 |

集群配置参考:

https://www.cnblogs.com/zhanglianghhh/p/9169263.html

https://www.cnblogs.com/toSeek/p/11981809.html

注意:本文归作者所有,未经作者允许,不得转载