1. Kafka需要依赖于Zookeeper,先安装Zookeeper

zookeeper需要依赖于jdk环境,需要先安装jdk环境

1.1 Zookeeper的单机安装

去官网Apache ZooKeeper下载zookeeper安装包,放到服务器目录/user/softs

解压:

tar -zxvf apache-zookeeper-3.7.1-bin.tar.gz

修改配置文件:

进入目录:

/usr/softs/apache-zookeeper-3.7.1-bin/conf

重命名文件:

mv zoo_sample.cfg zoo.cfg

修改数据目录:

vi zoo.cfg

修改dataDir=/usr/softs/apache-zookeeper-3.7.1-bin/data

防止centos自动清除tmp文件夹内容

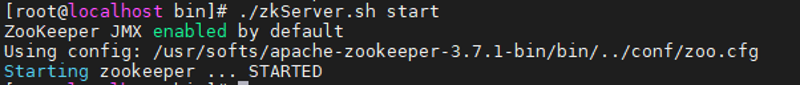

启动zookeeper:

/usr/softs/apache-zookeeper-3.7.1-bin/bin/zkServer.sh start

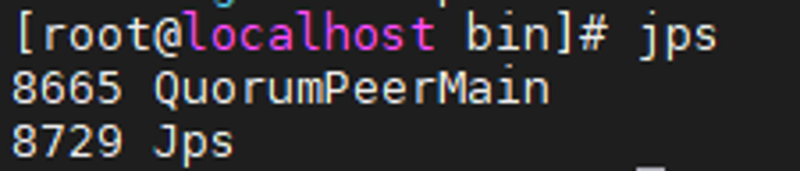

验证是否启动成功:

jps

或者:

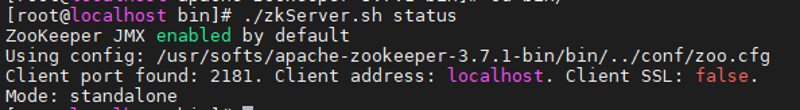

/usr/softs/apache-zookeeper-3.7.1-bin/bin/zkServer.sh status

查看运行状态和启动端口,和运行模式mode: standalone表示单机模式,follower,leader表示是集群模式

表示启动成功,如果不成功可以去logs文件夹下查看日志

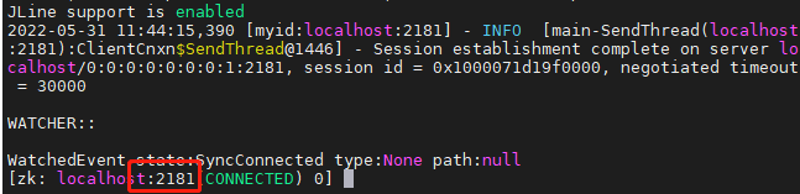

启动客户端,操作zookeeper:

/usr/softs/apache-zookeeper-3.7.1-bin/bin/zkCli.sh

默认连接本机2181端口的zookeeper

操作命令:

ls 查看目录

create /test hello 创建节点/test,并存储数据hello

get /test 查看节点存储的信息

deleteall /test 删除节点(递归删除)

退出客户端:

ctrl+c

或者:

quit

停止zookeeper:

/usr/softs/apache-zookeeper-3.7.1-bin/bin/zkServer.sh stop

1.2 Zookeeper的集群安装

多台机器,按单机方式安装、配置zookeeper

多出的配置:

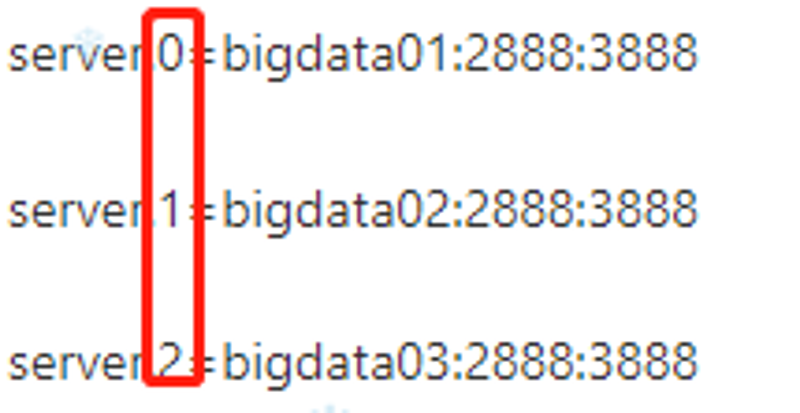

在zoo.cfg最后添加集群节点

server.0=bigdata01:2888:3888

server.1=bigdata02:2888:3888

server.2=bigdata03:2888:3888

注意:

2888集群通信的端口,3888集群选举leader的端口

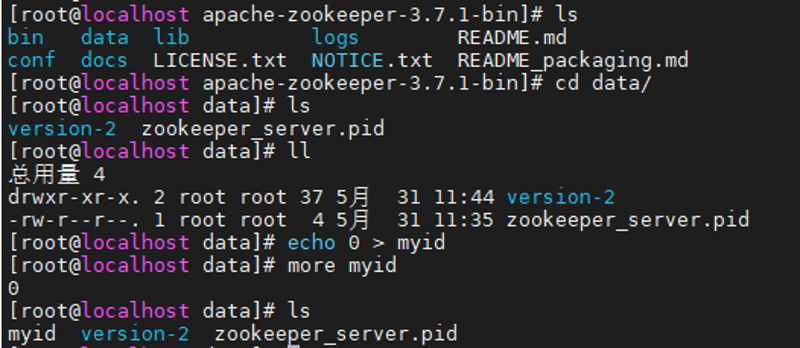

创建目录保存myid内容

mkdir /usr/softs/apache-zookeeper-3.7.1-bin/data

cd data

创建myid文件

保证每个节点myid文件里的值要和对于节点的编号相同

改完一个节点配置后可以拷贝到其他节点:

scp -rq /usr/softs/apache-zookeeper-3.7.1-bin bigdata02: /usr/softs/

拷完后记得修改节点的myid值

集群启动:

需要挨个启动每个节点的zookeeper启动方式和启动单机模式一样

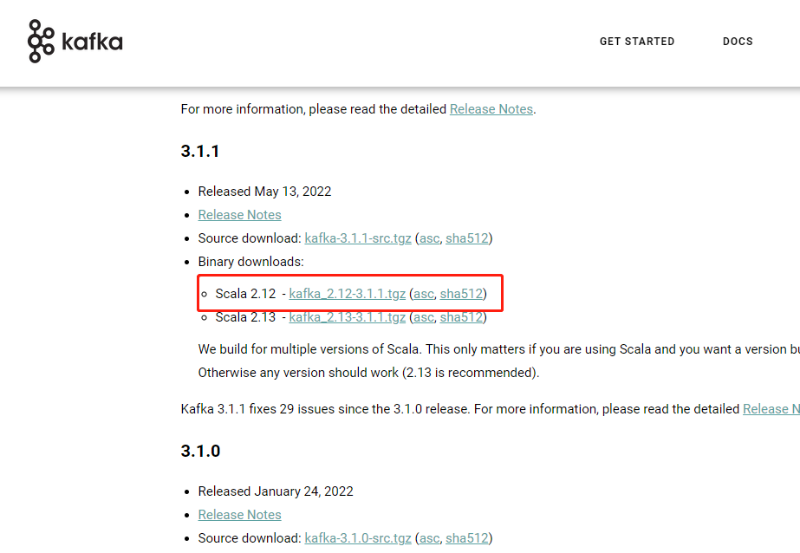

2.1 Kafka的单机安装

下载安装包:Apache Kafka

解压:

tar -zxvf kafka_2.12-3.1.1.tgz

修改配置文件:

进入目录:

/usr/softs/kafka_2.12-3.1.1/config

修改配置文件:

vi server.properties

broker.id=0 #集群安装时设置集群节点ID

log.dirs=/usr/softs/kafka_2.12-3.1.1/kafka-logs #设置数据文件路径,并不是日志路径

zookeeper.connect=localhost:2181 #单机版默认连接本机的zookeeper

#listeners=PLAINTEXT://:9092 默认监听9092端口,如果修改的话可以在这里修改

启动kafka:

./bin/kafka-server-start.sh -daemon config/server.properties

-daemon #意思是后台运行

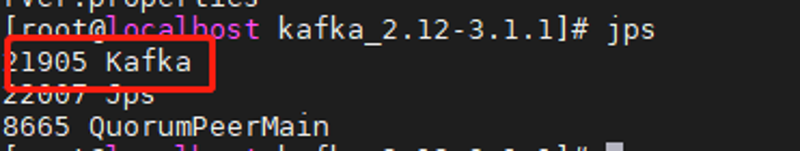

检验是否启动成功:

jps

停止服务:

./bin/kafka-server-stop.sh

2.2 Kafka的集群安装

多台机器,按单机方式安装、配置kafka

多出的配置:

在/usr/softs/kafka_2.12-3.1.1/config/server.properties设置集群节点ID

broker.id=0 #每个节点设置一个节点ID

设置log.dirs=/usr/softs/kafka_2.12-3.1.1/kafka-logs #设置数据文件路径,并不是日志路径,选择一个大的目录

设置zookeeper集群地址,配置多个集群节点地址:

zookeeper.connect=bigdata01:2181,bigdata02:2181,bigdata03:2181

改完一个节点配置后可以拷贝到其他节点:

scp -rq /usr/softs/kafka_2.12-3.1.1 bigdata02: /usr/softs/

拷完后记得修改节点的id值broker.id=1

集群启动:

需要挨个启动每个节点的kafka启动方式和启动单机模式一样

注意:本文归作者所有,未经作者允许,不得转载